Beaucoup de développeurs ont souligné rencontrer des problèmes avec les drivers de la console next gen de Microsoft la XBOX ONE . La récente mise à jour du SDK de la console permet l'emploi de sept des huit cœurs du CPU de la console au lieu de six initialement . Mais Microsoft a également mis en œuvre quelques améliorations importantes dans la mise à jour du mois d'Octobre .

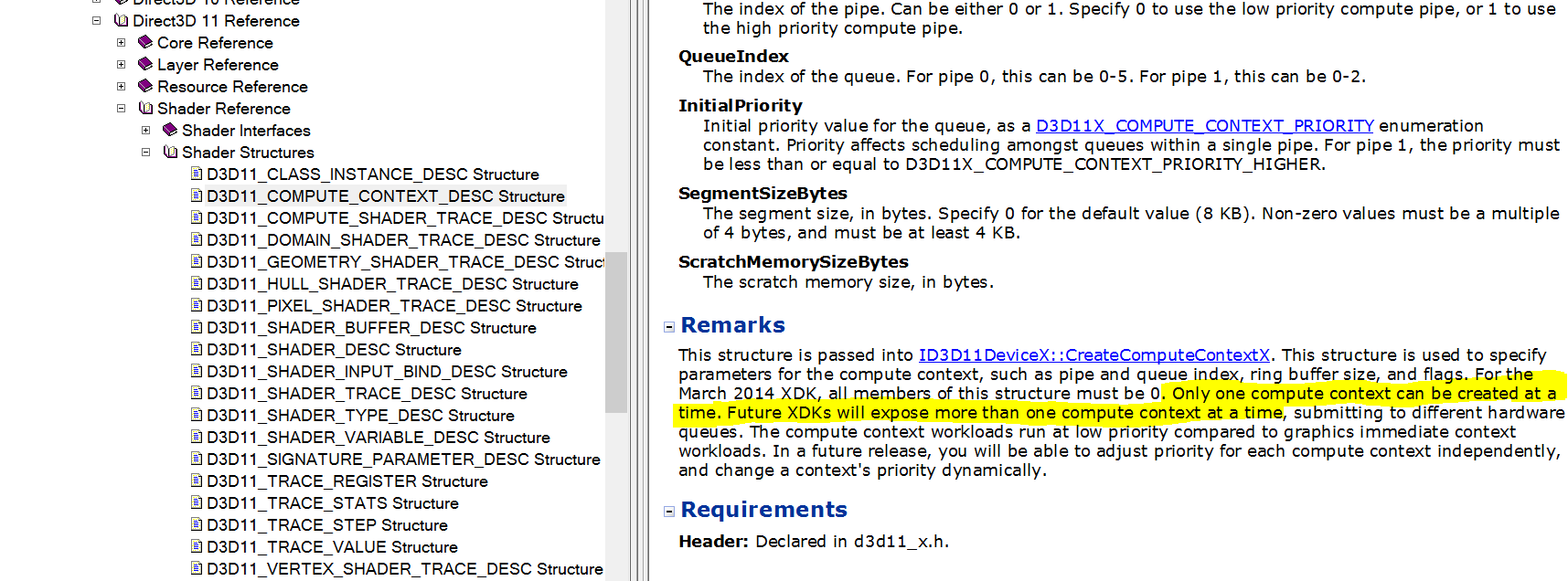

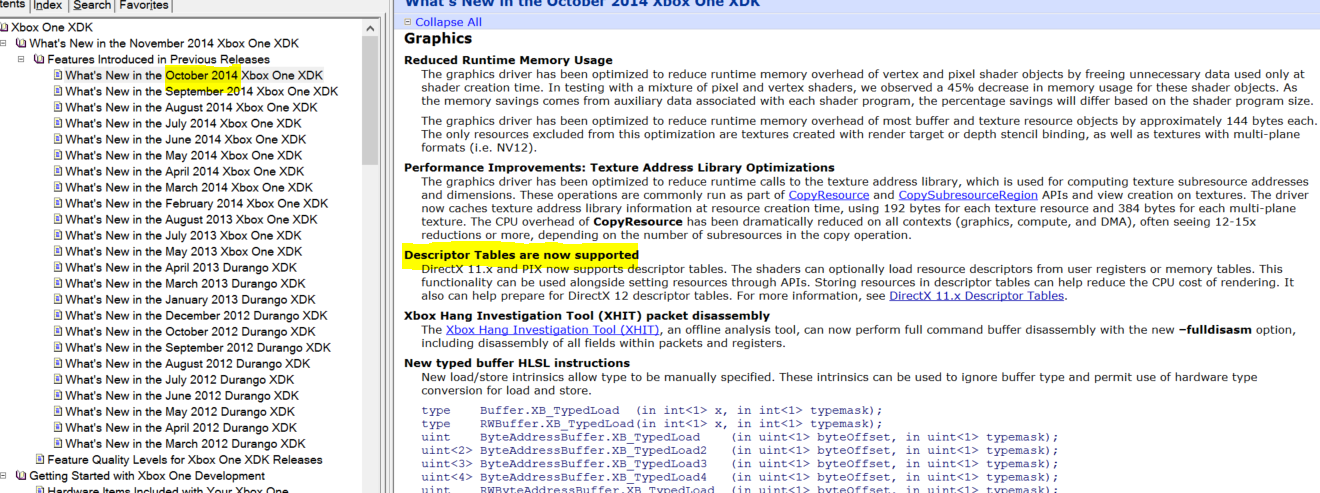

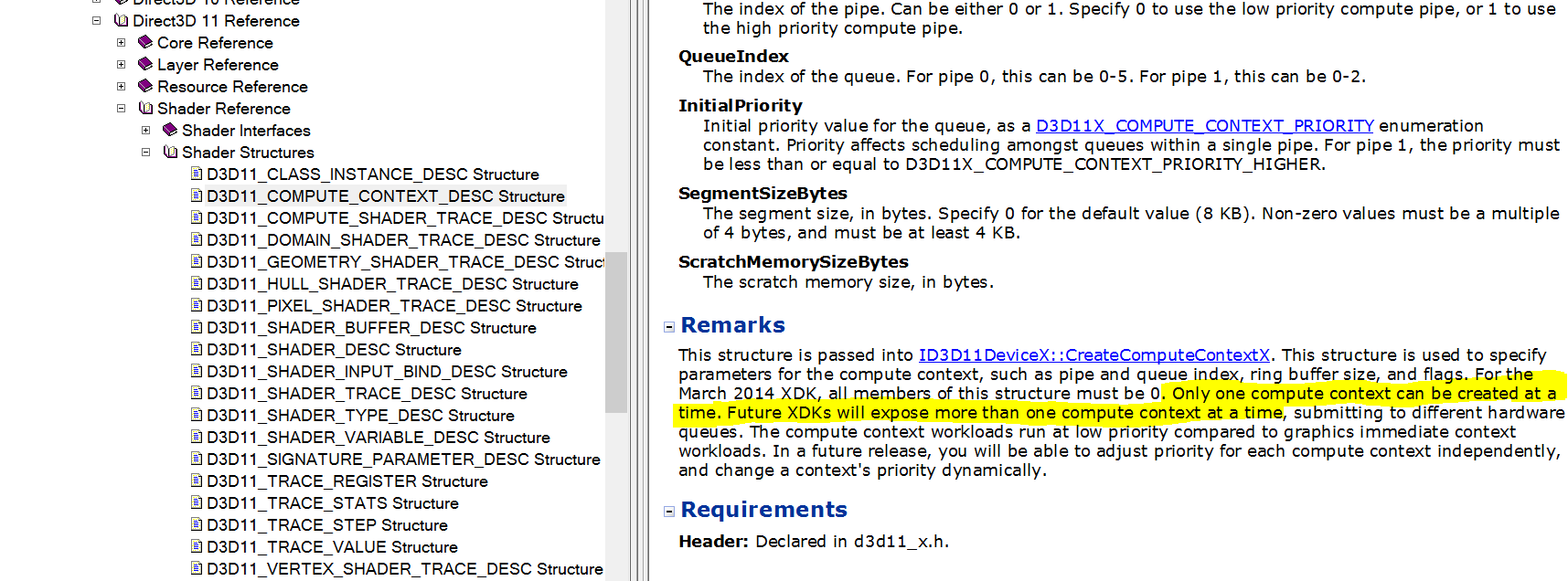

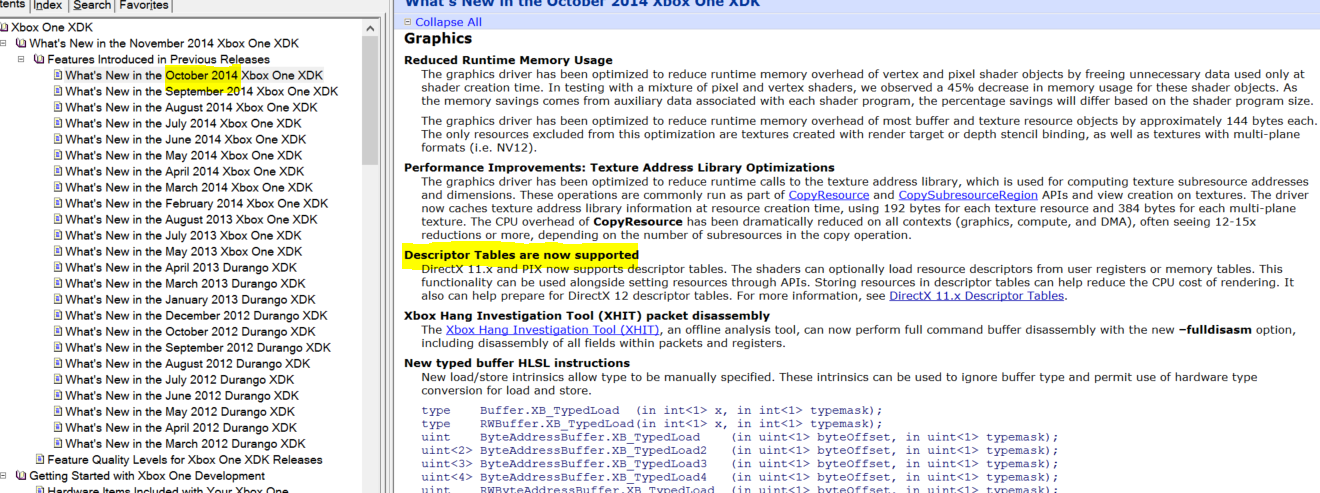

Cette information a été exposer par un membre de Union Video Game Forum qui a posté des images qui ont l’ère d’être des documentations sur le SDK de la console . Dans ces images deux éléments attirent l'attention , la première est que la mise à jour d'Octobre a réduit la quantité de mémoire utilisé quand on allume la console . Microsoft a réussi à le faire grâce à la mise à jour des pilotes graphiques . Selon les tests c'est une diminution de 45% de l'utilisation de la mémoire .

L'autre caractéristique de la mise à jour du mois d'Octobre était l'inclusion du soutien de la table globale de descripteurs . Une table globale de descripteurs définit les caractéristiques des différentes zones de mémoire utilisées lors de l'application du programme . Pour cette raison, les shaders peuvent charger descripteurs de ressources à partir des tables de mémoire qui peuvent aider à réduire le coût du CPU . La XBOX ONE est donc prêt pour DirectX 12 comme il peut soutenir la table globale de descripteurs de la nouvelle API .

Et bien sûr depuis il y aura encore eu du progrès de fait au niveau optimisation.

gat Hey ! T'es plutôt beau gosse toi.

Je sens que le prochain Gears of War 4 va être une véritable boucherie visuelle

Le CPU ne s'occupe pas de la partie graphique. Par contre, ce sera un bon point pour le framerate.

Par contre, une franche amélioration des capacités de la mémoire permettra un meilleur rendu (plus haute résolution par exemple). Mais ça, je n'y crois pas un seul instant.

Zaclorde > rien à branler de la résolution, tout ce que je veux c'est que le jeu éclate la rétine comme les deux premiers Gears of War en leur temps, et avec toutes ces améliorations apporté par Microsoft, autant dire tout de suite que c'est très bien partie

Bref, vivement les premières images et vidéos

J'ai absolument rien pigé sur ce que raconte la news mais ça m'a l'air d'être une bonne nouvelle, donc je suis content aussi

Ca me rappelle la petite phrase de Penello il y a 1 ans

http://www.gamekyo.com/newsen54330_apenello-microsoft-il-n-y-a-aucune-chance-qu-on-laisse-30-d-avance-a-sony.html

mike760

The Division en 1080p sur One parfait

C'est pas de la narcolepsie, c'est juste la moustache qui est trop lourde

Bordel elle est collector celle la

Pour le CPU, je suis 100% d'accord. Ils ont rendu un core supplémentaire pour les jeux. C'est du concret. Mais le CPU ne se charge pas de la partie graphique. C'est quand même un avantage pour d'autres domaines.

Pour l'ESRAM, c'est du baratin pour moi. En tout cas, dit comme ça.

mike760 nobleswan

N'en reste pas moins qu'on attend toujours cette qualité graphique en 1080p sur One. Il ne fait aucun doute que la One fera largement mieux, mais en 900p...

zaclorde de toute façon la résolution et moi

J'y ai pensé mais je me suis dit que ça ne risquait pas de faire fuhrer dans la rue et dans les lieux publics

Pour le moment, le moins que l'on puisse dire, c'est qu'il n'y a eu aucun changement.

Que les jeux s'améliorent graphiquement, c'est juste la logique qui se passe sur chaque genération. Faire passer ça pour une augmentation de performances, c'est se foutre du monde. Si vraiment il y a une augmentation de performances, on doit voir un changement de la résolution et du framerate.

Je suis persuadé que cela n'arrivera pas. J'attends de voir pour me marrer

Bien kiffant la forêt. En fait, tous les chapitres le sont car y'a tellement peu de jeux qui ont pour contexte l'Empire Romain... Et c'est bien dommage...

PS : L'avant dernier chapitre à Rome !

Ils en sont à indiquer les optimisations logicielles pour faire esperer 5% de perfs en plus xD

Pauvres fanboys pro M

C'est comme SOny, ms a delivré une machine catastrophique niveau hardware, et les gens achetent ces daubes...

Pauvres fanboys !

j'avais compris le sens générale mais pas les explications techniques. enfin bref, tant mieux, j'espère juste que toute ses ressources rendues dispos pour les développeurs ne vont pas créer de problèmes ailleurs.

Non, mais Kinect en paie de plus en plus le prix (en tout cas pour le 7ème core) : http://www.eurogamer.net/articles/digitalfoundry-2015-microsoft-gives-more-cpu-power-to-xbox-one-developers-blog

Je crois que ce sera le seul inconvénient.

gat First Light pas encore fait mais on dirai que cette fille est pleine de charisme

Bref désolé de polluer cette news par une reponse digne de ces trolls mais ces mecs si ils n'arrivent pas a se faire remarquer ou a faire devier le topic, ils sont frustrés comme des branquignols qui n'arrivent pas a rentrer dans une boite de nuit...

je n'ai pas kinect sur one mais personnellement je trouve dommage de se priver des features de kinect pour gagner quelques pixels...

mike760

Il n'y a plus qu'à espérer que les développeurs en fassent bon usage.

lightning mais ce Raphy26 exagère quand même sinon raoh38 ne te fatigue pas à répondre à cette énergumène

blackbox

gat

(Je précise j ai jamais joué a un killzone :good

Je n'ai joué qu'à KZ2 qui était impressionnant à sa sortie. Je peux pas te donner raison ou non pour Shadow Fall...

sur ps4 je n ai que the last of us mouai bof et ff14 qui est MAGNIFIQUE

Par contre, je doute pas FH2 soit une baffe vu que FM4 est très beau encore aujourd'hui.

Ryse est vraiment beau. Mais pas la claque que j'attendais.

C'est vraiment le pire des moteurs pour une console comme la One. Du full deffered en 1080p natif, la taille du G-buffer doit être énorme (j'avais lu un truc du style supérieur à 80 Mo), sans doute plus que Drive Club (qui fait bcp de deffered aussi mais moins que Killzone SF). Je pense que l'esram ne pourrait jamais encaisser des buffers de cette taille même en "compressant" à fond via du tiling/virtual texturing.

La One aura des jeux aussi beaux à l'avenir, c'est fort probable mais si on parle de technique pure le moteur de Killzone SF c'est vraiment le truc pas du tout adapté à l'architecture mémoire de la One. Ce serait même se tirer une balle dans le pied que de tenter ce genre d'approche sur cette console.

En règle générale mieux éviter de tenter des trucs pour laquelle le hardware n'est pas fait et se concentrer sur ses forces plutôt.

tu dis que la ONE est mal équilibré ,,,,, tu te fou de nous ou quoi !! ?

la PS3 avec un gros CPU ( le cell ) + un GPU à 256 mo tout petit !!

la PS4 avec un gros GPU (gddr5) + un cpu (fermé sur lui méme) sans dialogue possible avec le cloud pour le futur . ne compare pas le cloud gaming de sony et le cloud computing de la xbox .

Microsoft équilibre justement le CPU + GPU avec le software , le hardware + le cloud computing !!

on reviendra cracher sur la one dans 2 ans ok !!

Heureusement qu'il y a les first party et quelques studios (même indé) qui ont pris de l'avance de ce coté parce qu'autrement c'est pas rassurant.

De toute façon, la plupart ici achètent des consoles pour jouer aux exclus donc comme ça c'est plié =P

Moi aujourd'hui, la One vient de me foutre sa baffe technique (pour moi) ET ludique avec mon achat, pas prévu, de FORZA HORIZON 2 !

blackbox quel fou j'ai été, j'ai failli passer à côté de FH2, un des jeux de courses ultime du moment !!

Je l'ai commencé ce soir et j'avais du mal à en décrocher.

Beau, splendide, fun, super gameplay, musique au top, ultra complet et généreux dans tous ses modes et sa quantité inombrable de caisses !!!!!!!

Un truc de fou ce jeu, je suis dégouté que Microsoft ne l'ai pas assez soutenu en pub pour le vendre bien. Car j'ai vérifié les chiffres de ventes de cette merveille, c'est vraiment pas mérité...

Bien content de l'avoir finalement pris ce jeu, en édition Day One d'ailleurs! J'ai trois belles caisses offertes !

Microsoft a complètement loupé la mise en vente de son jeu de course ultime, ils ont vraiment chier dans le pâté sur ce coup et je leur en veux!

la xbox et sont Live WHOUA ! WHOUA !

n'en déplaise au This is For The Players .

Il a raison !

La preuve en images :

Halo4 remastered : http://images.eurogamer.net/2013/articles//a/1/7/1/9/4/1/0/7.bmp.jpg

Killzone : http://www.gamersyde.com/pop_images_killzone_shadow_fall-23879-1.html

C'est clair que la technique de Shadow Fall n'est pas du tout adaptée à la One à cause de la lenteur de sa mémoire.

En 1080p et en utilisant le même moteur, je crois que ce jeu serait impossible sur One, même en fin de vie. Le GPGPU ne changerait rien au fait que la mémoire est trop lente.

Après, on peut toujours obtenir des résultats similaires de façon détournée.

Quoiqu'il en soit, cette console n'est pas adaptée pour faire tourner des jeux ambitieux en 1080p. Tout le monde le sait, enfin ceux qui sont un minimum renseignés.

Le 1080p pose problème sur One pour 2 raisons : mémoire trop lente + pas assez de ROPs. La plus grosse contrainte reste la bande passante.

Pourquoi de plus en plus de jeux seront en 1080P sur One, si c'est problématique

92i Foxstep Raphy26,Alors les BEE GEES ça rage ce matin coups, ça va ce matin?

parce qu'ils pensent que seul le deffered rendering existe alors que d'autres techniques comme le forward+ rendering sont aussi efficaces voire meilleures

Le deferred rendering est la meilleure option. Ceci étant, il existe de très bonnes alternatives.

Sinon, il faudrait que tu m'expliques pourquoi les développeurs s'emmerdent à utiliser une technique très coûteuse en bande passante alors que, selon toi, il est possible de faire aussi bien voir mieux avec moins ?

J'espère que tu te rends compte que cela n'a aucun sens...

Par exemple Forza Horizon 2 utilise le forward+ rendering.

Et le rendu est très clairement inférieur à ce que propose Drive Club pour l'éclairage...

Crytek sur Ryse

Qui confirme bien la règle : impossible d'avoir un jeu en 1080p avec du deferred rendering sur One...

Nope. Mais alors pas du tout.

The Order c'est majoritairement du forward et j'adore sa tech.

Comme pour d'autres, il faut reprendre les bases avant de discuter de quoi que ce soit : apprendre à lire.

Ça dépend du jeu. Je pense que Killzone SF particulièrement exigeant.

Côté multi, il faudra surveiller les résolutions de MGSV (les jeux qui utilisent le Fox Engine en général) et de FFXV. A mon avis il y a peu de chances que ces deux jeux tournent en 1080p sur One (surtout le deuxième, même sur PS4 le 1080p n'est pas encore assuré).

Je pense qu'ils ont choisit de faire passer le 4xMSAA en priorité. Après, c'est une question de compromis et de ce qu'on veut mettre sur l'écran. Le forward, si il consomme moins de bande passante, demande beaucoup trop de calculs quand les sources lumineuses sont nombreuses.

Pour résumer, une scène complexe en matière d'éclairage va taper sur la bande passante avec le deferred.

Une scène complexe en matière d'éclairage va taper sur les ressources CPU et GPU avec le forward. C'est pour ça que les jeux qui utilisent le forward n'ont jamais un système d'éclairage très avancé, car cela flinguerait littéralement les performances du jeu.

Drive club a son style propre et ses choix de gameplay et de liberté ont été dictés par la cible graphique qui necessitait des sacrifices..fh2 'est pareil mais dans l'autre sens...et puis tu me parles de moteur moderne ben si celui de konami est si moderne que cela il devrait s'adapter a tous les supports, et le cryengine qui lui est superieur n'a pas cette escuse, car ils tournent tres bien sur tous les supports meme sur la ps3...

Ryse etait en 900p deja pour un titre de lancement, sans reserve de puissance kinect, sans les dernieres mises a jour, le sdk de l'epoque etant particulierement inefficaces a l'epoque...a croire que tu aimes bien ignorer ses elements...le jeu aujourdhui serait en 1080p a coup sur...de plus tu parles d'un jeu comme pes qui tourne deja en 720 p sur x360 et 60 fps, aucune escuse , ce n'est pas un titre de lancement, c'est d'ailleurs le seul a tourner de cette facon depuis 6 mois avec le jeu de golf

Oui et il ont besoin d'une grande diversité de materials également (The Order estle plus avancé dans ce domaine à l'heure actuelle) ce qui alourdit grandement le g-buffer quand tu passes par du deffered rendering. Il vaut mieux favoriser une solution forward pour ça même s'il faut baker le GI à la place (ça ne doit pas être la seule raison mais cela y a contribué je pense).

le jeu aujourdhui serait en 1080p a coup sur...

Merci de sortir ça de nulle part. Continue à parler dans le vent...

de plus tu parles d'un jeu comme pes qui tourne deja en 720 p sur x360 et 60 fps

Source ?

kayama

Ils ont sûrement plein de raisons, c'est certain

92i faudrait il que tu es le jeu pour parler...

Pour le sujet et dommage qu'il y a encore qui vienne faire du hors sujet on sait pourquoi, microsoft travaille tres dur,et c'est un travail tres propre ce deblocage d'une partie du septieme core...je pense que tout le monde pensait qu'avec 3 os en simultané , se devait etre plus gourmand pour la xbox mais force est de constater que tout est parfaitement optimisé, et windows 10 devrait encore amelioré la situation...si kinect etait completement abandonné,on aurait 7 core entierment dediés pour les jeux

zaclorde et toi pourquoi tu affirmes le contraire ? sur quoi tu te bases ? moi sur le faite que laxone est beaucouop plus exploitable maintenant qu'il y a 2 ans (lorsque le developpemnt de ryse a commencé), c'est juste de la logique de le penser...mais bon comme maintenant on a des fuites je peux te montrer que grace a la mise a jour le contenu cible peut a la fois transité par l'esram et la dram donc la limitation de celle ci n'est plus un argument...

Tient lit tout et revient ensuite avant de parler " Sur Xbox On l'effet de DRAM affirmation est beaucoup plus grande qu'elle ne l'était sur Xbox 360, avec le résultat étant que ce est beaucoup plus facile pour le CPU et le GPU à ralentir les uns les autres.

Optimisation pour réduire la bande passante mémoire est une stratégie clé pour Xbox One. Nous recommandons fortement que, le cas échéant, les titres envisager d'adopter la conception axée sur les données, car cela peut avoir le plus grand effet sur la performance du titre. ESRAM est le moyen le plus efficace de réduire DRAM affirmation, mais il ne est disponible que pour le GPU ".

Il semble que la présence (et l'aide!) Esram est essentiel de permettre à la CPU et GPU pour exécuter simultanément sans caler une autre. Avec le SDK Décembre ajoutant des fonctionnalités améliorées pour la gestion des esram, les choses se présentent bien pour les futurs xbox une [g]titres." ou encore Il ya une page sur une scission de rendre l'échantillon cible, mais malheureusement il n'a pas beaucoup d'infos. La photo montre environ 70% de la cible rendent dans ESRAM et 30% dans la DRAM. Ce serait le top 20% de l'écran et le fond 10% de l'écran dans la DRAM. Ils disent qu'il n'y a généralement pas beaucoup de overdraw dans le ciel et la terre. On dirait que z, g et de couleur tampons sont toutes divisées, mais sont capables de répartir différemment selon les besoins. Mentions HTile doit résider dans ESRAM, mais je ne sais pas ce que ce est (en supposant qu'il a quelque chose à voir avec les ressources carrelés. Le tampon de tuiles?).[/g]

Le topic en question https://translate.googleusercontent.com/translate_c?depth=1&hl=fr&rurl=translate.google.com&sl=auto&tl=fr&u=https://forum.beyond3d.com/threads/xbox-one-november-sdk-leaked.56362/&usg=ALkJrhhEMFPyxgteZSMu_V5XbzPwmLo_hA

Sunset Overdrive te salue bien. Voilà sur quoi je me base...

Soit ils font comme d'autres studios et choisissent une solution hybride (un mix) soit ils conservent la même approche et cherchent des astuces qui permettent d'économiser de la bande passante mémoire (comme pour l'esram) ce qui parait un peu casse-gueule mais pas impossible. Tout dépendra aussi de leurs choix artistiques.

zaclorde en parlant de Sunset Overdrive, plus de 6 mois avant la sortie du jeu j'avais anticipé que le jeu ne tournerait pas en 1080p natif (et avec quelques compromis au niveau de la résolution des buffer alpha et de l'AA). Le temps m'a donné raison comme quoi on ne raconte pas que des conneries

http://www.xboxygen.com/News/18458-Sunset-Overdrive-tourne-en-resolution-900p-et-30-fps

Et pourquoi ISS tourne en 1080p ?

Le deferred rendering est la meilleure option. Ceci étant, il existe de très bonnes alternatives.

Non, pas forcement la meilleure. Cela dépend de ton jeu.

Sinon, il faudrait que tu m'expliques pourquoi les développeurs s'emmerdent à utiliser une technique très coûteuse en bande passante alors que, selon toi, il est possible de faire aussi bien voir mieux avec moins ?

Peut être que les moteurs actuels utilisent essentiellement du Deffered ? Tu penses qu'on change de mode de rendering en claquant des doigts ? Le Forward+ rendering est assez récent. De plus forcement chaque technique a des avantages/inconvénients qui ne s'adaptent pas forcement à tous les hardware/moteurs.

Par exemple Forza Horizon 2 utilise le forward+ rendering.

Et le rendu est très clairement inférieur à ce que propose Drive Club pour l'éclairage...

Tes gouts ne sont pas apparemment partagés par tout le monde... D'autant que comparer un jeu de couloir à un open world...

Crytek sur Ryse

Qui confirme bien la règle : impossible d'avoir un jeu en 1080p avec du deferred rendering sur One...

Non plus mais c'est plus difficile car il faut optimiser et ne pas utiliser l'ESRAM pour le G-buffer entier. C'est plus une question de compromis. A la limite même si cela limite au 900p, vu que Ryse est à l'heure actuelle le plus beau jeu console, est ce bien grave ?

kayama parce qu'ils pensent que seul le deffered rendering existe

Nope. Mais alors pas du tout

The Order c'est majoritairement du forward et j'adore sa tech.

Comme pour d'autres, il faut reprendre les bases avant de discuter de quoi que ce soit : apprendre à lire.

C'est donc plutôt rassurant pour la One alors ? Attention, je parle de Forward+ rendering, pas du Forward normal.

Kayama en parlant de Sunset Overdrive, plus de 6 mois avant la sortie du jeu j'avais anticipé que le jeu ne tournerait pas en 1080p natif (et avec quelques compromis au niveau de la résolution des buffer alpha et de l'AA).

Tu as la source ? J'ai du raté ce passage. Je me rappelle qu'ils ont privilégié le nombre d'éléments affichés à l'écran mais je ne me rappelle pas de cela.

Cette facon d'avoir 2 discours differents c'est juste pathetique...

choubidou Sunset Overdrive : 900p + FXAA basique + alpha effets en low res (pas toujours), un LOD agressif par moment etc. tout ça est dans l'analyse de DF (mais pas seulement, on en discutait aussi sur les forums de B3D à l'époque).

Bien entendu, le jeu a plein de qualités techniques.

De plus moi j'ai eu vraiment les 2 jeux sur x360 et xone et le reliftage est vraiment impressionnant, je ne m'attendais pas a un tel resultat...343 industrie avait fait un boulot magnifique avec ce jeu recompensé par plusieurs titres de meilleur graphisme...

Même chose pour Crytek avec Ryse.

Il n'y absolument aucune raison pour que ce ne soit pas le cas étant donné l'écart de specs entre les deux machines.

En quoi c'est une question de gout ?

http://www.eurogamer.net/articles/2014-12-11-driveclub-dynamic-weather-tech-gallery-2

De plus avec ton raisonnement tu sais mariokart aussi serait meilleur sur ps4,meme halo ect sauf que ce sont des jeux esclus....

Qu'essayes tu encore de dire ? que si killzone ou infamous etait sur pc ils tourneraient mieux ? sa on le sait sau que ces jeux ne sont PAS sur cette plateforme comme sunset n'est pas sur ps4...

En tout cas je retiens plusieurs de tes affirmations lorsuqe tu dis predisais aussi par exemple que la ps4 ferait de meilleures ventes que la ps3 ou encore qu'aucun jeu de la xone meme en fin de vie n'atteindra la qualité de infamous et la tu en conviendras, tu vas devoir encore redescendre sur terre et se des 2015...

Outre le faite que c'est HS vu qu'on parle éclairage, beaucoup de gens kiff les années 90.

Nuance.

Et aussi que la One n'est pas faite pour le 1080p natif du fait de son architecture mémoire contraignante en particulier pour les jeux qui sont très exigeants au niveau de la bande passante (les jeux qui font bcp de deffered justement et qui sont riches visuellement).

Bref que des vérités incontestable sauf pour un fanboy de bas étage.

Le seul fail ici, c'est celui de ton cerveau.

La xone a certaines lacunes mais comme toute lacune tu peux les contoruner et c'est se que ms fait , et je trouve qu'il faut souligner leurs efforts a ce niveau..donc a l'avenir biensur que tous les jeux xone ne seront pas 1080p mais le gap de progression est quand meme assez fulgurant et les titres de 2015 risquent de le demontrer...

De tout temps chaque console a eu ses propres faiblesses, sa a toujours existait, et comme de tout temps les perfs au fur et a mesure du cycle de la console s'ameliorent...

Bref que des vérités incontestable sauf pour un fanboy de bas étage.

Le seul fail ici, c'est celui de ton cerveau.

Et moi aussi je t'ai demontré des fait incontestables des conneries que tu sors( pas toujours) des que tu parles de la xboxone...de tes predictions qui vont s'averer fausses, car tu as les chevilles qui ont legerement gonflés...tu devrais rester sur ta specialité, les consoles playstation...

Le probleme de ton "raisonnement "general c'est que tu joues a l'amnesique, les consoles ont toujours commencé comme sa doucement pour finir fort, la xone aura la meme trajectoire, 2015 et 2016 le prouveront, je n'ai meme pas le predire c'est se qui se passera...

Apres si tu veux commencer a glisser sur des comparaisons avec la ps4 se sera sans moi car c'est du hors sujet complet et sa ne servira juste pour toi de trouver une porte dérobée...encore une fois.

Tout sa pour dire que si playground avait décidé de faire un jeu de meme type que dc je suis sur qu'il aurait été meilleure globalement, apres comme tu dis c'est mon avis...

La PS4 l'est encore moins dans ce ce cas. Elle est totalement sous-exploitée à l'heure actuelle par les éditeurs tiers (utlisation très fréquente de convertisseur de code Directx11 via émulation sur le CPU, plus pourri tu meurs, pas de compute shaders ou très peu, le calcul asynchrone n'est pas encore d'actualité alors que c'est la spécialité du hardware et j'en passe).

Arrête de prendre tes rêve pour la réalité et évite de comparer avec la PS3. Son architecture exotique à base de Cell est restée pendant longtemps une énigme pour la majorité des développeurs (first party inclus). Rien à voir avec la nouvelle génération. Ce n'est pas du tout le même cas de figure.

Et pour ton histoire d'esram. Il y a quelque chose que tu n'as pas compris visiblement. Je t'ai déjà dit que l'esram contrairement l'edram n'a (à ma connaissance) pas de connexion directe avec les ROPs donc est moins limitante pour la taille du framebuffer à priori car en pratique cela ne change pas grand chose. Pourquoi ? Car les développeurs doivent toujours jongler en permanence entre deux pools mémoire (et faire des choix d'allocation de telle ou telle donnée en fonction des priorités) : tu as d'un côté 5 GB de DDR3 qui traine un peu la patte et un tout petit pool de 32 Mo d'esram 2 fois plus rapide donc idéal pour gérer certains effets comme les particules par exemple.

Le truc c'est que si les développeurs utilisent un moteur particulièrement exigeant coté bande passante, la première chose qu'ils vont sacrifier ce sera la résolution native, l'AA, la résolution des particules/buffers alpha voire tout en même temps et bizarrement c'est exactement ce que l'on observe quand on regarde les jeux de la One.

Je ne sais pas comment je peux expliquer les choses plus simplement que ça.

Elle permet de mieux gérer certaines choses (car plus de bande passante) mais sa quantité est trop limitée (32 Mo). C'est incontestable et tous les développeurs sans exception le savent.

Le défi ce sera de trouver des solutions pour éviter de la saturer trop rapidement et c'est d'ailleurs la priorité de MS dans les derniers SDK.

Vous comprenez cela vous avez tout compris et on a plus besoin d'en reparler

Tout sa pour dire que si playground avait décidé de faire un jeu de meme type que dc je suis sur qu'il aurait été meilleure globalement, apres comme tu dis c'est mon avis..."

Beaucoup de dammage control inutile et hors sujet, on parle de l'éclairage de forza (forward+) face a driveclub (deferred), pas de spéculation comme quoi si forza devient un RTS il dépassera starcraft 2.

De plus le dernier sdk 2.0 de la ps4 est apparu il y a quelque mois et c'etait 90% pour leur camera...ce n'est pas une priorité pour sony et sa peut se comprendre vu qu'ils ont deja depuis le depart de bons outils...

La ps3 en est un tres bon exemple au contraire car la memoire séparé a dut etre un sacré casse tete pour les inges de chez sony, et ils ont dut apporter pas mal d'amelioration sur le sdk pour cela...

Un autre exemple la super nes avait un cpu hyper faible mais de bons coprocesseurs a coté se qui lui permettait d'afficher un mode 7 et de plus beaux graphismes que la megadrive...la saturn aussi etait un defi pour les developpeurs...

Mais je trouve franchement que tu parles beaucoup sur la xboxone sans vraiment te renseigner et tu reste sur de vieilles positions alors que tu sais tres bien que sa evolue et heureusement...

Mais grace a ses documents on se rend compte que l'archi personnalisé de la xone est plus complexe que tu le dis, on voit par exemple qu'il est possible de faire bosser l'esram en continu , sans attente grace a sa tres faible latence, aidé par les dme integrés dans l'apu qui peuvent travailler en meme temps que l'esram sans consommer sa bande passante...bref toi qui aime les techniques tordus au contraire tu devrais etre content...justement tu louais cela a la ps3... la ps4 doit etre tellement ennuyeux sur ce point pour toi

Bouée de sauvetage c'est toi qui le dit,cela fait partie integrante de la conception de la xone comme les moteurs de deplacement, point...que ce ne soit pas le top c'est comme dire d'avoir choisit du jaguar comme cpu, ou d'utiliser de ggdrr5 pour un systeme d'exploitation, se sont des choix mauvais, moyens ou tres bons c'est comme sa...et le fait qu'il travaille dur pour ameliorer ses capacités est une tres bonne nouvelle ne t'en deplaise...

Tu peux forcement afficher de meilleurs effets en faisant un jeu dans un couloir , en diminuant le nombre de voitures ect ect...

Ce qui fait que le hardware PS4 n'est pas ''ennuyeux'' c'est le calcul asynchrone via le GPU (combiné au système hUMA ou équivalent). La PS4 est spécialisée la dedans (plus que la One et la Wii-U). C'est d'ailleurs ce qui fait qu'au final, le directeur technique de Q-Games adore cette console alors que c'est un gros fan du Cell.

Ce qui va être "ennuyeux" en revanche, c'est de voir que moins de 10% des développeurs l'exploiteront pleinement. Vive les exclus.

C'est faux, ils ont juste rajouté beaucoup plus d'effets et d'ennemis à l'écran.

"900p works perfect for us. We spent a lot of time comparing and contrasting. We had it running at 1080p, we'd play it; we had it running at 900p, we'd play it and they didn't look considerably different. But the things that you could draw on screen were a lot more, and we wanted to draw a lot more on screen. More action, more better. Michael Bay would be very proud."

Source : Sunset Overdrive Dev Explains Why It Chose 900p Over 1080p

Comme quoi tu dis un peu n'importe quoi...

Kayama Et bien entendu, Insomniac n'aurait eu aucun mal à faire tourner Sunset Overdrive en 1080p natif sur PS4 au moment de sa sortie et avec plusieurs améliorations ici et là.

Et bien attendu tu n'as aucune preuve de ce que tu avances. Regardes, moi aussi je sais le faire : "et bien entendu Insomniac n'aurait pas pu faire tourner Sunset Overdrive car ils auraient été CPU bound avec la PS4..." Pas la peine de preuve, on s'en fout....

lls le font tourner en 900p pour afficher tous leurs effets car en 1080p ils auraient été trop limités au niveau de la bande passante. Il faut savoir lire entre les lignes. Il y a des choses qu'ils ne peuvent pas dire explicitement pour ne pas fâcher leur partenaire commercial mais que l'on comprend facilement si on maitrise un peu le sujet.

Mais un cell partgant la meme memoire que le gpu aurait eu un sens, meme plus dans un soc...en meme temps avec leur apu c'est se qu'ils essayent de faire, profiter du gpu pour s'en servir pour faire des taches qui etaient destinées au depart au cpu...

Et se qui est aussi vrai ce sont bien les esclus qui profiteront de chaque hardware, nintendo y arrive tres bien en sortant des productions que l'on croyait impossible a faire dessus...

APres ceratins developpeurs ne se resoudront pas a garder une definition max en bridant le reste de leur jeu, pas juste techniquement mais aussi du gameplay....

lls le font tourner en 900p pour afficher tous leurs effets car en 1080p ils auraient été trop limités au niveau de la bande passante. Il faut savoir lire entre les lignes. Il y a des choses qu'ils ne peuvent pas dire explicitement pour ne pas fâcher leur partenaire commercial mais que l'on comprend facilement si on maitrise un peu le sujet.

Mais oui bien sur, raccroches aux branches comme tu peux... C'est mignon.

Parce que le moteur de PES n'a strictement rien à voir. Réponse simple.

choubidou

Non, pas forcement la meilleure. Cela dépend de ton jeu.

Jusqu'à preuve du contraire, c'est la technique la plus efficace. Comment peux-tu affirmer que le forward + est plus efficace en te basant sur l'unique exemple de Forza Horizon 2. Tu n'as absolument aucun recul pour faire une telle affirmation. T'as déjà entendu parler d'illumination globale avec du foward ???

Quelles sont les documents que tu possèdes sur le forward +. Un lien ?

Peut être que les moteurs actuels utilisent essentiellement du Deffered ? Tu penses qu'on change de mode de rendering en claquant des doigts ? Le Forward+ rendering est assez récent.

Tu parlais d'autres techniques. Quelles sont ces autres techniques mis à part le foward et le foward + ???

Le deferred a clairement l'avantage sur le foward, c'est incontestable. La question est déjà un peu plus nuancée pour le forward +.

Tes gouts ne sont pas apparemment partagés par tout le monde...

Ce n'est pas une question de goûts, c'est une question de faits. DC utilise un système d'illumination globale dynamique + à la fois le forward et le deferred = la meilleure solution possible.

Bref, tout ce que ne fait pas Forza Horizon 2...

Non plus mais c'est plus difficile car il faut optimiser et ne pas utiliser l'ESRAM pour le G-buffer entier. C'est plus une question de compromis. A la limite même si cela limite au 900p, vu que Ryse est à l'heure actuelle le plus beau jeu console, est ce bien grave ?

Cite moi un jeu en 1080p sur One qui utilise du deferred ? Même une solution moins coûteuse. Perso, j'en connais pas. Après, si t'es content d'avoir un jeu 2D en 30fps qui utilise du deferred sur One, tant mieux pour toi...

kayama

tu parles avec quelqu'un qui dit admettre la supériorité technique de la PS4 (quoique avec lui je suis pas sûr) mais qui n'accepte pas que la PS4 puisse faire tourner des jeux irréalisables à l'identique sur One. Voilà la logique du bonhomme

C'est exactement ça. À l'entendre, ISS tourne en 1080p sur PS4 parce qu'il est vide. Inversement, SO tourne en 900p parce qu'il y a plein d'ennemis à l'écran. Cela revient à dire que ISS pourrait tourner en 1080p sur One.

On sait tous que c'est faux.

Pourtant, le mec continue à dire que la PS4 est plus performante...

Tu peux forcement afficher de meilleurs effets en faisant un jeu dans un couloir , en diminuant le nombre de voitures ect ect..."

Merci de démontré que c'est pas une question de gout.

Et pour info, ISS tourne à 40-45fps de moyenne. Il est à plus de 30fps plus de 99% du temps. Les devs avaient encore de la marge sans rien modifier au moteur.

Tout ce que fait la One, la PS4 peut l'afficher en mieux. C'est aussi simple que ça. Tu peux te rassurer en pensant le contraire si ça te permet de mieux dormir la nuit.

Et cela ne fait pas de la One une mauvaise machine. Je n'ai d'ailleurs jamais dit ça.

Je dis juste que ça sert à rien de "believe" que les machines sont équivalentes alors qu'elles ne le sont pas. C'est tout

Je ne contredis en rien le studio (que j'apprécie beaucoup d'ailleurs et je n'ai pas attendu qu'ils développent une exlusivité Xbox pour ça

Et bien attendu tu n'as aucune preuve de ce que tu avances. Regardes, moi aussi je sais le faire : "et bien entendu Insomniac n'aurait pas pu faire tourner Sunset Overdrive car ils auraient été CPU bound avec la PS4..." Pas la peine de preuve, on s'en fout.... Ceci dit quand on voit ISS sur PS4 qui est CPU bound avec le peu de choses affichées à l'écran et sa gestion des ombres assez douteuses on peut se poser la question. Tu vois c'est facile de raconter n'importe quoi, je fais comme toi, pas la peine d'apporter des preuves, juste des affirmations, ça suffit.

Pourtant, c'est se qui se passe sur un tas de multis où la PS4, en plus de proposer une meilleure résolution, se permet d'afficher plus d'effets à l'écran. Donc, son argumentation possède une base empirique bien établie, soit tout le contraire de tes affirmations.

D'autre part, si Insomniacs dit vrai, il faudrait m'expliquer pourquoi les développeurs choisissent toujours le gameplay sur la résolution sur One ? Ceci démontre bien que Insomniacs raconte tout simplement n'importe quoi et qu'ils n'ont jamais été en mesure d'atteindre les 1080p.

[url="http://fr.slideshare.net/takahiroharada/forward-34779335"]Forward+ : Bringing defered ligthing to the next level[/url]

[url="https://www.youtube.com/watch?v=s2y7e3Zm1xc"] Leo DirectX forward plus rendering lighting[/url]

Ok, en fait tu ne sais pas de quoi tu parles en fait, tu ne sais même pas ce qu'est le Forward+ ...

Forward+ : Bringing defered ligthing to the next level

Leo DirectX forward plus rendering lighting

Ok, en fait tu ne sais pas de quoi tu parles en fait, tu ne sais même pas ce qu'est le Forward+ ...

Forward+ : Bringing defered ligthing to the next level

[url=kayama https://www.youtube.com/watch?v=s2y7e3Zm1xc] Leo DirectX forward plus rendering lighting[/url]

Kayama

Je ne contredis en rien le studio (que j'apprécie beaucoup d'ailleurs et je n'ai pas attendu qu'ils développent une exlusivité Xbox pour ça ).

Tu inventes un peu des choses qu'ils n'ont pas dit... Le jeu tournait en 1080p mais avec moins de choses à l'écran, c'est ce qu'ils disent clairement. Après tu peux "lire entre les lignes" comme tu dis mais c'est de la pure spéculation/affirmation sans aucunes preuves.

C'est pour cela que ces consoles peuvent faire du GPGPU. Et il existe un gouffre dans ce domaine entre la One et la PS4... si la PS4 reste à 6 cores, la One pourra faire falloir son avantage CPU sur les jeux développés de façon classique. Sur les jeux qui utilisent le GPGPU, cet avantage sera totalement écrasé et dérisoire.

Quoiqu'il en soit, le GPU sera toujours plus important que le CPU. Sinon, explique-nous pourquoi les 2 consoles ont des CPU de merde et des GPU performants... ton niveau de logique est pas croyable...

choubidou

Génial, la vidéo d'un commercial qui vend sa came et un lien qui ne dit rien. Sinon, les développeurs en disent quoi ???

Bref, c'est bien ce que je pensais. Tes dires sont basés sur du vent, absolument pas sur la réalité concrète du marché où le deferred domine. Tu n'as absolument aucun recul sur la situation.

Pourtant, c'est se qui se passe sur un tas de multis où la PS4, en plus de proposer une meilleure résolution, se permet d'afficher plus d'effets à l'écran. Donc, son argumentation possède une base empirique bien établie, soit tout le contraire de tes affirmations.

Heu... tu sais lire ? Oui, le deffered pose problème sans optimisation sur One. Et donc ? Je l'ai déjà dis. Peut être que les plupart des jeux actuels utilisent le Deffered ?

D'autre part, si Insomniacs dit vrai, il faudrait m'expliquer pourquoi les développeurs choisissent toujours le gameplay sur la résolution sur One ? Ceci démontre bien que Insomniacs raconte tout simplement n'importe quoi et qu'ils n'ont jamais été en mesure d'atteindre les 1080p.

OK, maintenant Insomniac ment...bon quoi rajouter ? Tu connais mieux leur jeu que eux même ?

PS: ce site est pourri pour discuter.

Mais par exemple tu prends le tegra ou les apu intel c'est beaucoup beaucoup plus efficace mais avec un gpu plus faible chez intel (et c'est plus cher), mais vu se qui arrive dans les années a venir se sera un choix supplementaire pour la prochaine gen...

Génial, la vidéo d'un commercial qui vend sa came et un lien qui ne dit rien. Sinon, les développeurs en disent quoi ???

Tu as lu le slide ? Tu ne sais pas utiliser Google ? Je vois surtout que tu parle de sujets qui te dépassent un peu. Ta faculté à critiquer une méthode de rendering que tu ne connais apparemment pas est assez comique je trouve.

Tes dires sont basés sur du vent, absolument pas sur la réalité concrète du marché où le deferred domine. Tu n'as absolument aucun recul sur la situation.

Renseignes toi, tu seras un peu moins ridicule...

Heu... tu sais lire ? Oui, le deffered pose problème sans optimisation sur One. Et donc ? Je l'ai déjà dis. Peut être que les plupart des jeux actuels utilisent le Deffered ?

Le rapport ? kayama dit que SO tournerait en 1080p sur PS4 et avec en plus de meilleurs effets. Tu dis que c'est du n'importe quoi, pourtant c'est se qui s'est passé sur un bon nombre de multi. Inversement, la One n'a jamais été capable de faire ça. Donc, c'est bien toi qui spécule le + ici.

Pas compliqué à comprendre...

OK, maintenant Insomniac ment...bon quoi rajouter ? Tu connais mieux leur jeu que eux même ?

Parce que le bullshit n'existe pas dans le milieu ? Guerilla n'avait pas dit que le multi de Killzone était en 1080p ? Faudrait juste que tu m'expliques pourquoi, systématiquement, les développeurs choisissent le gameplay sur One et le 1080p sur PS4. Cela n'a évidemment aucun sens.

choubidou

Et il dit quoi le slide ?

raoh38

Tu sorts ça d'où ?

Pour les tâches plus susceptibles à la latence ce n'est pas non plus un problème. Le système hUMA de AMD est justement là pour limiter ces problèmes.

Voici une très bonne intervention d'un développeur concernant l'intérêt du calcul asynchrone via le GPU :

"Asynchronous compute will increase the GPU utilization in the future games. Previously lots of GPUs cycles were wasted every time you had to do any kind of reduction operation (for example downscale for blur kernels, scene average brightness calculation, depth pyramid generation for culling, etc) or when you changed your render target and started reading the previous buffer as a texture. There were lots of stalling scenarios that allowed the GPU to sleep. Now the games will push commands from two (or more) queues, utilizing the GPU even when (big) stalls like these occur. With multiple kernels running simultaneously it is also much easier to utilize most of the GPU bandwidth and most of the excess ALU when the rendering is bound by the fixed function units (such as ROPs, depth buffering, front end and triangle setup).

It is more power efficient to run the GPU at lower clocks for the whole frame instead of running it with higher clocks and frequently stalling (and power cycling). As long as asynchronous compute doesn't trash your caches (a similar problem exists with Hyperthreading) it will be more power efficient than stalling + sleeping frequently."

C'est vraiment tout benef. On va enfin avoir avoir des GPUs correctement exploités pour les développeurs qui franchiront le pas (il faut que les APIs suivent aussi même si certains programmeurs sont assez forts pour briser les barrières via des hacks).

Et ça tue également le mythe comme quoi faire du computing sur le GPU se fait au détriment des graphs. Ça confirme ce que disait le développeur de Ready At Dawn ainsi que Mark Cerny. Il y a trop de cycles de perdus sur le GPU, ça va juste permettre de les récupérer et d'en faire quelque chose.

Et il dit quoi le slide ?

Tu sais pas lire ? C'est parce que c'est anglais ? Trop complexe pour toi ? Pourtant le slide vulgarise assez bien.

Le rapport ? kayama dit que SO tournerait en 1080p sur PS4 et avec en plus de meilleurs effets. Tu dis que c'est du n'importe quoi, pourtant c'est se qui s'est passé sur un bon nombre de multi. Inversement, la One n'a jamais été capable de faire ça. Donc, c'est bien toi qui spécule le + ici.

Le Deffered pose problème et nécessite des optimisations. De plus ici Insomniac précise bien que le choix a été fait par rapport au nombre d'objets et effets à l'écran et donc pas forcement lié à une problématique de mémoire disponible ou de bande passante mais plus de ressources GPU/CPU. Votre conclusion sur SO et la PS4 ne sont que des spéculations sans aucun fondement. C'est plus compréhensible pour toi maintenant ?

http://translate.google.fr/translate?hl=fr&sl=en&u=http://en.wikipedia.org/wiki/Jaguar_%28microarchitecture%29&prev=search

Mais c'est sur que plus le temps avance plus les devs consoles seront obligés d'aller pioché dans le gpgpu...mais bon si tu ameliores la partie cpu (surtout pour du low cpu)c'est tout benef pour les jeux aussi...et je comprend pourquoi ms pousse aussi dans ce sens vu qu'ils ont de meilleures perfs niveau cpu alors que sony pousse plus pour le gpgpu parce qu'ils ont un gpu plus efficace...mais ce sont des objectifs differents (attention quand meme ms ne crache pas sur le gpgpu ils bossent aussi sur cela) qui ont le meme but, proposer plus de performences pour les jeux et c'est se qui comptent au final...

Le slide ne dit rien de particulier et de surcroît n'est rien d'autre qu'un document officiel AMD (l'inventeur de la technique).

Bref, aucun intérêt.

Donc, je repose ma question. Les développeurs, c'est-à-dire les tiers et pas AMD, en disent quoi ? Spécifiquement ceux qui ne sont pas contraints d'utiliser le foward à cause de la faiblesse du hardware et qui ont le choix entre le deferred et le foward+ ?

Il n'y a aucun recul sur cette technique, mais tu crois pouvoir faire d'un unique jeu une règle générale et permanente. Merci pour la faiblesse de ton argumentation...

De plus ici Insomniac précise bien que le choix a été fait par rapport au nombre d'objets et effets à l'écran et donc pas forcement lié à une problématique de mémoire disponible ou de bande passante mais plus de ressources GPU/CPU.

Ah bon, parce qu'un GPU qui affiche + de choses à l'écran ne consomme pas + de bande passante ?

Votre conclusion sur SO et la PS4 ne sont que des spéculations sans aucun fondement.

C'est ça, les jeux qui tournent avec une plus basse résolution sur One et avec moins d'effets n'existent pas. Et si l'on parle simplement des jeux qui tournent dans une résolution plus basse, la famille s'agrandie encore...

raoh38

Bah donne le lien alors...

S'ils te disent que le GPGPU c'est l'avenir c'est que c'est le cas. Toute la communauté des développeurs le sait. Même Ubisoft (voir la présentation du programmeur de Ubisoft Montpellier à la dernière GDC).

Si Microsoft pousse un peu plus au niveau du CPU (tu fais référence à l'overclocking + le 7ème core ?) c'est pour une simple raison : ils savent que les tiers dans leur grande majorité utilisent tous DirectX sur PC et convertissent leur code directement sur consoles via des wrappers quasi-automatisés sans véritable effort d'optimisation ce qui est une abbération pour la PS4 qui n'est pas prévue pour supporter DirectX à la base (Sony a intégré un émulateur Directx pour ceux qui ne veulent pas se prendre la tête et convertir leur code facilement sur toutes les plateformes, résultat : même les gros studios le font ce qui pathétique).

Donc oui dans ce cas de figure (approche fainéante du développement), ça peut être utile de concentrer ses efforts sur le CPU.

Mais c'est une solution provisoire qui permettra juste de limiter la casse car à terme tout le monde se mettra aux compute shaders. Certains attendent juste l'arrivée de Directx12 PC et Direct 12.x sur One pour s'y attaquer sérieusement.

Certains programmeurs qui codent en assembleur ont déjà commencé à taper dedans via leurs propres hacks mais ce sera plus efficace quand tout sera officialisé dans les futures SDK.

D'ailleurs amd stagne a ce niveau et sa fait un moment qu'on attend la releve...

Sur pc le gpgpu n'est meme pas prioritaire pour les developpeurs a cause que les cpu majoritaierment intel sont beaucoup plus puissant...et que la memoire n'est pas partagée...nvidia et surtout amd appuit sur cela car ils sont clairement en retrait niveau cpu...et que intel qui controle 65 % du marché des gpu va avoir des apu extremement performent dans les années a venir...

Ensuite biensur que les programmeurs aiment le gpgpu surtout sur console mais il n'en demeurent pas moins que le cpu est toujours tres important, le programmeur principal de cdprojekt ou celui de frosbite ont deja dit que c'etait le plus gros facteur limitant...

gat c'est bien vu que tu ne m'interressais pas plus que cela je n'ai pas pris le temps de chercher sur google comme tu l'as fait

Bref, aucun intérêt.

Le slide t'explique la technique, si tu n'y comprends rien je ne peux rien pour toi.

Donc, je repose ma question. Les développeurs, c'est-à-dire les tiers et pas AMD, en disent quoi ?

Demande à Playground Games pour FH2 : open world, 1080p 30fps 4xMSSA sans broncher et graphismes unanimement salués.

Sinon tu peux aussi trouver la technique sous le nom de "tiled forward" ou de "tile based forward" il me semble.

Spécifiquement ceux qui ne sont pas contraints d'utiliser le foward à cause de la faiblesse du hardware et qui ont le choix entre le deferred et le foward+ ?

A la base le Forward+ rendering n'est pas lié à une contrainte hardware mais est une évolution du Deffered et du Forward car le Deffered a aussi ses limites et le Forward simple est limité. Après, tu adaptes généralement ton moteur au hardware sur lequel tu travailles, cela me semble normal, c'était déjà la cas sur 360 et PS3. De plus le Forward+ n'est réellement possible qu'avec le DirectCompute dispo depuis Dx11 et sera encore mieux supporté par Dx12.

Il n'y a aucun recul sur cette technique, mais tu crois pouvoir faire d'un unique jeu une règle générale et permanente. Merci pour la faiblesse de ton argumentation...

Tu sais, cette technique est déjà utilisée...tu t'enfonces mon pauvre.

Ah bon, parce qu'un GPU qui affiche + de choses à l'écran ne consomme pas + de bande passante ?

Non mais la il faut revenir à la base de tes connaissances de rendering 3D. La bande passante et les ressources CPU/GPU ne sont pas forcement liés. Je commence à m'interroger sur l'étendue de tes connaissances...

C'est ça, les jeux qui tournent avec une plus basse résolution sur One et avec moins d'effets n'existent pas. Et si l'on parle simplement des jeux qui tournent dans une résolution plus basse, la famille s'agrandie encore...

Au début oui, maintenant cela a tendance à se globalement se resserrer. Après le problème n'est pas forcement le même suivant le jeu. Pour l'instant force est de constater que le problème principal venait surtout du XDK... Peut être que je me trompe mais si tu prends l'exemple de Destiny, il me semble qu'au départ c'était essentiellement un problème de ressources GPU, aucun rapport avec un problème éventuel avec la bande passante puisque la libération des ressources de Kinect via la mise à jour du XDK a permis le passage en 1080p... Un interview des devs de Metro Redux montre aussi un gros problème essentiellement provoqué par une mauvaise optimisation du XDK et de Dx11.

Bref, je suppose que nous n'avons pas la même vision des choses ou que nous ne les comprenons pas de la même façon, ce n'est pas bien gênant. Je me contenterai de me foutre de vous lorsque les prochains titres comme Quantum Break ou Halo 5 vous en mettront plein la vue...en 1080p.

Kayama Ce qui fait que le hardware PS4 n'est pas ''ennuyeux'' c'est le calcul asynchrone via le GPU (combiné au système hUMA ou équivalent). La PS4 est spécialisée la dedans (plus que la One et la Wii-U).

En quoi la One ne serait pas spécialisé la dedans aussi ? Et le DirectCompute/Compute Shader intégré à Dx11/12 ? Je ne comprends pas trop ta "démonstration". Sinon, pour le hUMA avec la PS4/One, l'état de l'art est assez flou je trouve, je ne serai pas aussi catégorique que toi :

Sony PlayStation 4 (PS4) will NOT utilize AMD hUMA with Kabini-based SoC

AMD HUMA – PS4 and Xbox One Memory System Analysis

En ce qui concerne l'hUMA, j'ai lu l'avis de plusieurs devs là dessus et tout démontrent que la PS4 est équipé d'un système équivalent. Un employé de AMD l'avait mentionné également sur les forums de B3D (c'est à ce moment là qu'on a appris que Sony a beaucoup influencé AMD pour l'architecture Kaveri et les séries suivantes).

C'est d'ailleurs ce qui explique les gains de perfs énormes observés pour les tâches réalisés via le GPU au lieu du CPU (par exemple Q-Games économise pas moins de 6ms sur son pipeline de rendu, les tests de Sony montrent du x10 pour la physique, ceux d'ubisoft pour le cloth simulation idem etc.). Cela est possible car le CPU et le GPU ont accès aux mêmes datas sur le même espace virtuel ce qui facilite les échanges et évite les temps ''idle'' ou le CPU doit attendre une réponse du CPU pour compléter sa tâche et vice-versa (par exemple pour la gestion de l'IA, du path finding/visibilité). Sans ce genre de système, on perdrait des cycles GPU et/ou CPU et les gains de perfs ne seraient pas aussi importants.

Le système hUMA (ou équivalent) est le meilleur ami du GPU computing et il est bien présent dans la PS4 (pour la One, il semblerait que non). Les volatile bits sont également un gros avantage pour l'utilisation de compute shaders (voir le post du dessus en anglais).

Pour beaucoup le point de départ sera la sortie de Directx12 sur PC, ça va bousculer un peu les choses (Mantle faisait déjà tout ça mais bon...MS a plus de poids c'est comme ça).

On peut au moins compter sur les first party pour faire le job. Pour le moment ça commence pas trop mal pour certains d'entre eux et je pense que les autres prennent le temps de se mettre à la page pour mieux nous surprendre ensuite.

Ton lien ne dit rien...

choubidou

Le slide t'explique la technique

On peut également tout simplement considérer que c'est le marchant de tapis qui vend son produit. Ton lien est totalement inutile en plus de ne pas être suffisamment détaillé.

Demande à Playground Games pour FH2 : open world, 1080p 30fps 4xMSSA sans broncher et graphismes unanimement salués.

Le 1er Forza faisait déjà du 720p 4xMSAA sur 360. Désolé de te refroidir. Les jeux de voitures n'ont pas les mêmes contraintes.

Sinon, ce lien est déjà plus intéressant et neutre. À quel moment les développeurs disent que cette technique est supérieure au deferred ???

Réponse : jamais.

Le forward+ ressemble donc à un joli compromis, rien de plus. Il préserve mieux les performances que le simple forward tout en permettant un éclairage satisfaisant, mais sans jamais atteindre le niveau permis par le deferred.

Ce n'est pas pour rien si les solutions d'éclairage les + impressionnantes sur consoles sont toutes à base de deferred : Drive Club ou encore Unity.

Si tu veux une technologie vraiment révolutionnaire qui met toutes les autres à l'amende, va voir du côté de The Tomorrow Children.

A la base le Forward+ rendering n'est pas lié à une contrainte hardware mais est une évolution du Deffered et du Forward car le Deffered a aussi ses limites et le Forward simple est limité.

Mais bien sûr... tout comme le FXAA est une évolution du MSAA.

De plus le Forward+ n'est réellement possible qu'avec le DirectCompute dispo depuis Dx11 et sera encore mieux supporté par Dx12.

Je ne sais pas d'où tu sorts ça, mais c'est une solution AMD à la base. Il n'y a aucune raison qu'elle favorise DirectX. Question de logique...

Tu sais, cette technique est déjà utilisée...tu t'enfonces mon pauvre.

Un autre exemple à part Forza Horizon ? Un jeu qui n'est même pas foutue de faire de l'illumination globale (même baked) en dépit de sa technique du "future" ?

Non mais la il faut revenir à la base de tes connaissances de rendering 3D. La bande passante et les ressources CPU/GPU ne sont pas forcement liés.

Tu peux être clair et précis au lieu de noyer le poisson dans des phrases qui ne veulent rien dire ?

Peut être que je me trompe mais si tu prends l'exemple de Destiny, il me semble qu'au départ c'était essentiellement un problème de ressources GPU, aucun rapport avec un problème éventuel avec la bande passante

Qui a dit que c'était un problème de bande passante ?

la libération des ressources de Kinect via la mise à jour du XDK a permis le passage en 1080p.

Et tu crois à ces conneries ?

GPU One = 1,31 Tflops en comptant les 10% / 10% de 1,31 = 0,13 Tflops

GPU PS4 = 1,84 Tflops / 1,84-1,31 = 0,53 Tflops

Donc, avec 0,13 Tflops on passe facilement du 900p au 1080p.

Question, pourquoi le jeu ne tourne pas en 4K sur PS4 avec 0,53 de Tflops en + ?

Je ne reviens pas sur l'utilité du GPUGPU je veux juste que tu m'explique en quoi la One ne serait pas aussi doué que la Ps4

Parce que son GPU est moins puissant pour commencer.

Ensuite :

Xbone: 1.31 TF GPU (12 CUs) for games

Xbone: 768 Shaders

Xbone: 48 Texture units

Xbone: 16 ROPS

Xbone: 2 ACE/ 16 queues

PS4: 1.84TF GPU +40% (18 CUs) for games +50%

PS4: 1152 Shaders +50%

PS4: 72 Texture units +50%

PS4: 32 ROPS +100%

PS4: 8 ACE/64 queues +300%

Les ROPS et les ACE servent pour le GPGPU. Suffit de voir le déficit de la One à ce niveau...

http://www.redgamingtech.com/playstation-4-vs-xbox-one-gpu-performance-information/

Enfin, renseigne-toi un peu : http://www.cinemablend.com/games/PS4-Clobbers-Xbox-One-Ubisoft-GPU-Benchmark-67877.html

Bref...

On peut également tout simplement considérer que c'est le marchant de tapis qui vend son produit. Ton lien est totalement inutile en plus de ne pas être suffisamment détaillé.

T'es un peu ridicule la quand même. Il ne te vends rien du tout, il t'explique leur technique de rendering. Tu n'y comprends rien, il n'y a pas de honte à avoir...

Le 1er Forza faisait déjà du 720p 4xMSAA sur 360. Désolé de te refroidir. Les jeux de voitures n'ont pas les mêmes contraintes.

Par rapport à quoi ? Tu es censé démontré quoi exactement la ?

Sinon, ce lien est déjà plus intéressant et neutre. À quel moment les développeurs disent que cette technique est supérieure au deferred ???

C'est une autre technique de rendering, c'est tout. Je ne vois pas ou tu veux en venir.

Je ne sais pas d'où tu sorts ça, mais c'est une solution AMD à la base. Il n'y a aucune raison qu'elle favorise DirectX. Question de logique...

Sérieux, tu ne comprends vraiment rien mon pauvre. Tu sais faire la différence entre une technique et son application ? Le forward+ rendering utilise le DirectCompute quand c'est appliqué sous DirectX. C'est toujours possible d'une autre façon mais plus complexe à mettre en oeuvre.

Tu peux être clair et précis au lieu de noyer le poisson dans des phrases qui ne veulent rien dire ?

Etres plus clair et précis ? Ok, tu ne sais pas de quoi tu parles et tu mélange bande passante avec des problématiques de CPU/GPU disponible. C'est plus clair ? Pour faire simple puisque que apparemment cela à l'air d'être difficile pour toi, tu peux être CPU/GPU bound sans maximiser la bande passante. Ton moteur attend le résultat des calculs ou ta pile d'exécution est pleine.

Qui a dit que c'était un problème de bande passante ?

Vous ? Puisque vous dites que l'ESRAM et la bande passante pose des problème avec les méthodes de Deffered rendering. Si tu te perds toi même dans tes propres arguments je ne peux plus rien faire pour toi...

Et tu crois à ces conneries ?

Oui, quand ce sont les développeurs eux même qui le disent. Je ne comprends pas très bien pourquoi ils mentiraient sur ce jeu. Dans quel but ? C'est ta réponse quand tu ne sais plus quoi dire ?

Parce que son GPU est moins puissant pour commencer.

Certes, sur le papier en effet. Et donc, dans le concret cela se traduit par quels gains exactement ?

Enfin, renseigne-toi un peu

Le test de Ubisoft est fait sous Dx11, avec un vieux XDK, sans utilisation de l'ESRAM, et donc limité par la bande passante de la DDR3. Et oui, renseignes toi toi aussi...

Bref, en effet... Je suppose qu'on n'arrivera pas à conclure de toute façon, tu es persuadé que la PS4 est une machine surpuissante et que la One est complétement à la rue incapable de faire du 1080p. Cela ne me dérange pas mais j'ai hâte de voir Quantum Break et Halo 5 pour voir un peu ce que vous allez trouver comme nouvelle explications...

Sur ce, j'en ai fini pour ce topic. Je te laisse le soin de conclure et de te défouler !

T'es un peu ridicule la quand même. Il ne te vends rien du tout, il t'explique leur technique de rendering. Tu n'y comprends rien, il n'y a pas de honte à avoir...

Et ce n'est rien d'autre qu'une promotion de leur technologie.

Par rapport à quoi ? Tu es censé démontré quoi exactement la ?

Du 1080p 4xMSAA est censé être un truc de fou sur FH2. Je te dis simplement que FH faisait déjà du 720p 4xMSAA. Mis à part l'upgrade logique vers le 1080p, je ne vois pas la révolution ?

Le vrai plus de FH2, ce sont ses lumières dynamiques.

C'est une autre technique de rendering, c'est tout. Je ne vois pas ou tu veux en venir.

Tout comme le forward classique

Soudainement, tu ne clames plus que cela donne de meilleurs résultats ?

Sérieux, tu ne comprends vraiment rien mon pauvre. Tu sais faire la différence entre une technique et son application ? Le forward+ rendering utilise le DirectCompute quand c'est appliqué sous DirectX. C'est toujours possible d'une autre façon mais plus complexe à mettre en oeuvre.

Et comment les portages PC font pour tourner sur PS4 ?

Pourquoi tu faits des remarques totalement inutiles ?

Pour faire simple puisque que apparemment cela à l'air d'être difficile pour toi, tu peux être CPU/GPU bound sans maximiser la bande passante.

Voilà, c'est plus clair. À quel moment je dis le contraire ?

Maintenant, est-il est trop compliqué pour toi de comprendre qu'être limité par la bande passante revient à être artificiellement GPU bound, car le GPU est de fait sous-utilisé ?

Vous ? Puisque vous dites que l'ESRAM et la bande passante pose des problème avec les méthodes de Deffered rendering. Si tu te perds toi même dans tes propres arguments je ne peux plus rien faire pour toi...

Oui, sur ce jeu spécifiquement ? Maintenant, il semble que le jeu utilise un moteur à base de deferred. Je ne le savais même pas. Coup de chance pour toi, puisque tu ne semblais pas être au courant.

Malheureusement pour toi, le SDK en question donnait également plus de bande passante pour le GPU : http://www.eurogamer.net/articles/2014-06-04-xbox-one-dev-kits-receive-more-gpu-bandwidth

D'autre part, il est évident qu'un moteur à base de deferred mettra à mal la bande passante de la One selon l'ambition technique du jeu. On ne peut pas dire que Destiny soit impressionnant de ce côté là...

Oui, quand ce sont les développeurs eux même qui le disent. Je ne comprends pas très bien pourquoi ils mentiraient sur ce jeu. Dans quel but ? C'est ta réponse quand tu ne sais plus quoi dire ?

Et tu fais quoi des 0,53 Tflops en plus de la PS4 ? Tu les ignores parce que tu n'as rien à dire. Parce que cela démontre ton manque total de logique et de cohérence.

Et surtout, tu connais la réso du jeu avant le SDK ? Réponse : non.

Une fois de plus, tu parles dans le vent.

Certes, sur le papier en effet. Et donc, dans le concret cela se traduit par quels gains exactement ?

Par du 720p/60fps sur le dernier PES 2015, par exemple. Ou encore un FarCry4 et un Mordor en 900p.

Le test de Ubisoft est fait sous Dx11, avec un vieux XDK, sans utilisation de l'ESRAM, et donc limité par la bande passante de la DDR3. Et oui, renseignes toi toi aussi...

Source de tes élucubrations ?